本文主要翻译自HarshaAngeri发表在Medium上的博客《FutureofAIisBiological》,文中加入了一些自己的阐述与理解。

人工智能源于人类大脑,人类所具备的智能是有机的、自然的大脑神经细胞活动(神经智能,NI),但现今我们所说的人工智能(AI)还属于计算机、机器人和软件代码这些范畴,目前的机器学习功耗和大数依赖据不可持续,这种局面将会继续保持下去还是会逐渐演变为追求基于生物活动的开发?

本文将阐述机器的学习瓶颈使得基于干细胞的神经网络前景广阔。

当前人工智能的瓶颈:

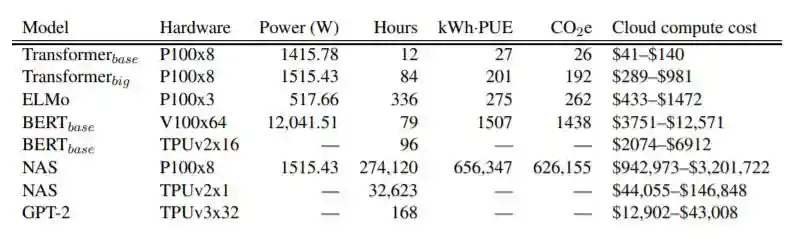

功耗巨大:AI机器计算是变快了,但是功耗也变得更大,马萨诸塞大学阿默斯特分校的研究人员最近为AI培训建立了基准(下图)。可以看到从基本的tramsformer到当下流行的GPT2再到神经网络架构搜索(NAS)效果越来越好的同时耗能越来越大(简直是eneryisallyouneed!),当这些模型耗电1000瓦时,大脑仅仅需要20W。

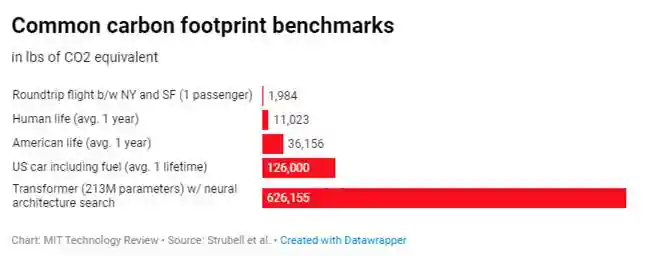

对于气候变化而言是不可持续的,如下图所见,训练神经网络搜索AI模型所产生的二氧化碳比普通美国汽车多5倍。

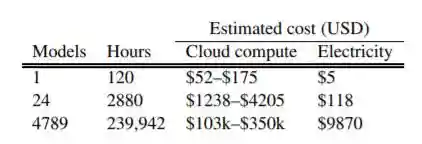

而且一般不会局限训练一个模型,而是要调参来达到最佳AI模型。同一位研究人员分析了R&D中的典型模型调整,发现需要进行数千次运行。因此,上面提供的数字是最小值。它乘以运行次数即epoch。

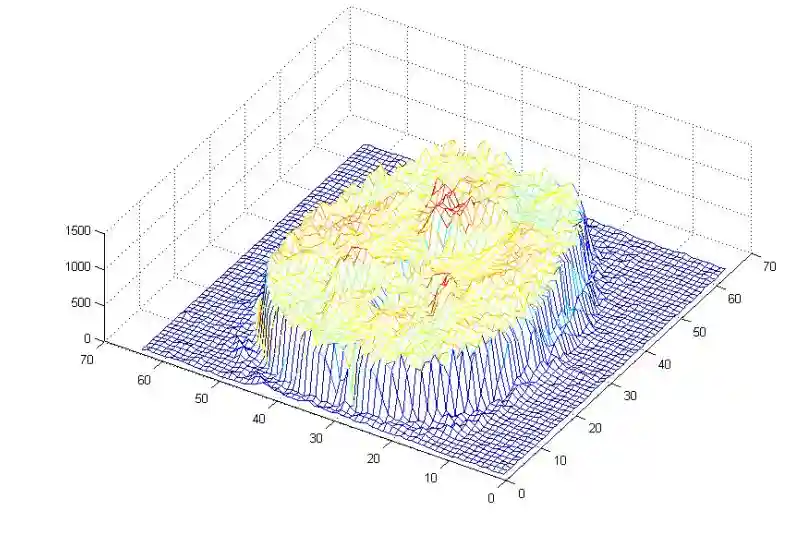

任务局限性:消耗了这些能量后,我们得到了什么?狭窄的单任务问题解决方案。复杂的对话需要串行多个AI模型。这与神经智能NI完全不同,后者既可以串行也可以并行,比如看电影时,可以做到同时听,看和想象。以下是来自大脑成像研究的图像,该图像显示了针对视觉运动任务并行运行的50个独立过程。

特征表示问题:首先,深度学习中的数据以稠密形式表示(思考为什么用wordembedding放弃one-hot),而大脑似乎具有稀疏表示。什么意思?初次遇到的情景,大脑皮质某神经元做数据表示,当再次看到它们时,该组神经元就会被触发。基于特征、轮廓等的深度学习将所有面部都混合在同一网络中。代表较稀疏的大脑因此可以更好地处理噪声。通过遮住一半的脸,您无法愚弄大脑,但是即使引入很少的像素,也可以在触发网络的不同部分时欺骗AI。

学习方式问题:首先,如今,人工智能系统需要数千张猫的图像才能找出猫。大脑神经智能NI是以已有的知识为基础并进行推断。这意味着大大降低了计算量和能耗。

其次,自然智能NI具有对诸如重力和其他物理学之类的知识编码层,我们可以与稀疏矩阵的其他部分无缝且并行地连接,从而在未知情况下扩展我们的知识,童年时期,父母何时教我们如何利用重力?并没有。在婴儿时期就利用它,并且在生命的早期就知道不抓紧的东西会掉下来。

边缘案例问题:当今AI存在问题的核心就是边缘问题,尤其是无人驾驶领悟。举个极端例子,为了制造出强劲的自动驾驶汽车,人工智能应该训练它不要从悬崖上走下来,但你又不能将汽车推下悬崖进行训练,所以将永远没有足够的数据点来得到可靠的模型。神经智能NI就是这样诞生的……我们看到重力神经元触发了悬崖,我们知道会跌倒。边缘案例永远没有足够的数据,这就是为什么它们被称为边缘案例。这是自然智能NI结构可以替代人工智能的一个基本悖论。

列举了人工智能的目前存在的问题,以及对大脑神经智能的劣势。那么人工智能将如何更好地借鉴神经智能?

借鉴新皮质层:大脑中的NI结构非常复杂,目前仍在研究中。但是我们在某些方面达成了普遍共识。新皮质层是大脑中与更高阶功能相关的部分。已经明确大脑的不同部分处理不同的感觉,但这些不同区域的基础结构(列,连接等)是相似的,单位面积皮质表面的神经元数量也差不多。它们彼此不同的主要是输入。比如用音频作为视觉区域的输入,它将仍然可以学习和工作。与AI截然不同,但这种结构是否可以在当前人工智能结构中借鉴与重构?

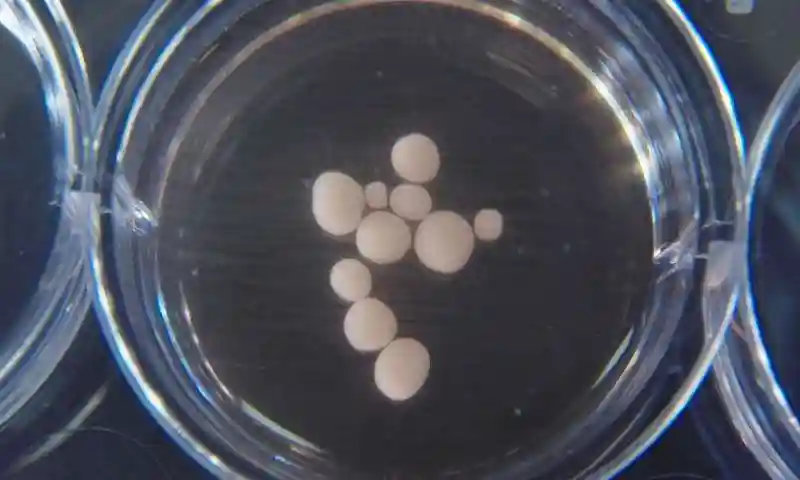

类脑干细胞:实验室中使用干细胞在培养皿中生长,参见下图。

干细胞组织类似于大脑,是一个低能耗的神经网络,它们自组织成神经组织。科学家在重复制造它们并通过提供血管/血管生长使其稳定以保持更长的时间方面取得了长足的进步。它们也已经成长并显示出各种功能,例如视网膜细胞(原始的眼睛),从而使我们进入了传感成为可能的时代。这些类器官会像人的大脑一样产生脑电波。最近,已经都无法区分9个月大的大脑类器官和早产儿的婴儿大脑的脑电波。

生物计算(Biologicalcomputing):这些类器官组织将自组织并在数月内发育。可以指导他们进行特定的活动吗?一系列的试验表明是可以的。最近,加州大学戴维斯分校和哈佛大学的一个团队演示了一种DNA计算机,该计算机运行了21种不同的程序(例如:复制,分类,识别回文以及3的倍数等),表现出了可持续的低能耗。

展望

目前基于分子编程/生物计算,干细胞和类器官,基因编辑(CRISPR)的特定开发取得极大进步,未来,从这些结构衍生出神经计算模型,将使得AI类似于大脑的学习成为现实。

令人兴奋。